目录

淘宝分布式业务系统是如何实现高效稳定的电商运营的?

田沐霖

·

2025-03-06 00:58:37

阅读6分钟

已读2906次

淘宝分布式业务系统作为支撑海量用户、商品和交易的核心架构,在双十一等高流量时期展现出了卓越的性能。通过多层次架构设计,包括负载均衡层、应用服务层、数据存储层和消息队列层,以及解决数据一致性、容错与恢复、性能优化等关键技术难题,确保了系统的高可用性和可扩展性。同时,实战案例证明了该系统能够应对巨大流量冲击,为用户提供流畅的购物体验。对于其他电商企业来说,淘宝的成功经验提供了宝贵的借鉴,包括重视基础设施建设、采用微服务架构等方面。

用户关注问题

淘宝分布式业务系统是如何提高交易处理速度的?

您有没有遇到过在淘宝购物高峰期,感觉页面加载变慢、付款响应时间变长的情况呢?那淘宝分布式业务系统是怎么解决这个问题,让交易处理速度更快的呢?

淘宝分布式业务系统通过多种方式提高交易处理速度:

1. 数据分片:将庞大的用户数据和商品信息按照一定规则分散到不同的数据库节点上。例如,按用户ID的哈希值分配到不同数据库,这样可以避免单一数据库的压力过大。

2. 负载均衡:

- 利用智能算法合理分配用户请求到不同的服务器

- 当某台服务器负载过高时,自动将新请求引导至空闲服务器

3. 缓存机制:对热门商品、常用页面等进行缓存,减少对后端数据库的直接访问次数。

4. 异步处理:对于一些非实时性操作(如订单状态更新),采用异步消息队列处理,确保核心交易流程快速完成。

如果您想深入了解这些技术细节,欢迎点击免费注册试用我们的系统,或者预约演示,我们将为您详细解读。

淘宝分布式业务系统如何保障高并发下的数据一致性?

在淘宝这种超大规模的电商平台,同一时间可能会有成千上万笔交易同时发生,那它是怎么保证这么多交易的数据都准确无误,不会出现错账、漏账的情况呢?

淘宝分布式业务系统采用了一系列策略来保障高并发环境下的数据一致性:

1. 分布式事务管理:

- 基于两阶段提交协议(2PC)或TCC模式

- 确保跨多个数据库节点的操作要么全部成功,要么全部失败

2. 幂等性设计:

- 对于重复请求,系统能够识别并只执行一次有效操作

- 防止因网络波动导致的重复下单等问题

3. 最终一致性模型:

- 允许短期内存在数据差异

- 但通过定期校验和修复机制,在可接受的时间范围内达到一致

4. 强一致性场景优化:

- 针对支付、库存等关键环节,采取更严格的同步机制

- 确保资金安全和库存准确

为确保您的业务也能获得同样的稳定性,我们建议您点击免费注册试用,亲身体验这套成熟可靠的解决方案。

淘宝分布式业务系统在应对流量高峰时有哪些优势?

像双11这种大型促销活动时,淘宝肯定要面对海量用户的同时涌入,那它这个分布式业务系统有什么特别之处能扛住这么大的流量冲击呢?

淘宝分布式业务系统在应对流量高峰时具有以下显著优势:

1. 弹性伸缩能力:

- 根据实时流量情况自动调整资源分配

- 在高峰期迅速增加服务器实例,在低谷期释放闲置资源

2. 智能路由调度:

- 基于地理位置、网络状况等因素优化用户请求路径

- 减少延迟,提升用户体验

3. 多层防护机制:

- 流量清洗中心过滤恶意攻击流量

- 限流、降级策略确保核心服务稳定运行

4. 混合云架构支持:

- 结合公有云与私有云资源

- 实现成本效益最优的资源配置

从SWOT分析角度来看:

| 优势(Strengths) | 劣势(Weaknesses) |

|---|---|

| 强大的技术研发实力 | 初期部署成本较高 |

| 丰富的实战经验积累 | 对运维人员要求较高 |

| 机会(Opportunities) | 威胁(Threats) |

| 适应新兴业务需求 | 面临新技术挑战 |

| 拓展海外市场潜力 | 法规政策变化风险 |

如果您希望为自己的业务构建类似的高效能系统,欢迎预约演示,我们将为您提供专业的咨询服务。

免责申明:本文内容通过 AI 工具匹配关键字智能整合而成,仅供参考,伙伴云不对内容的真实、准确、完整作任何形式的承诺。如有任何问题或意见,您可以通过联系 12345@huoban.com 进行反馈,伙伴云收到您的反馈后将及时处理并反馈。

热门内容

推荐阅读

最新内容

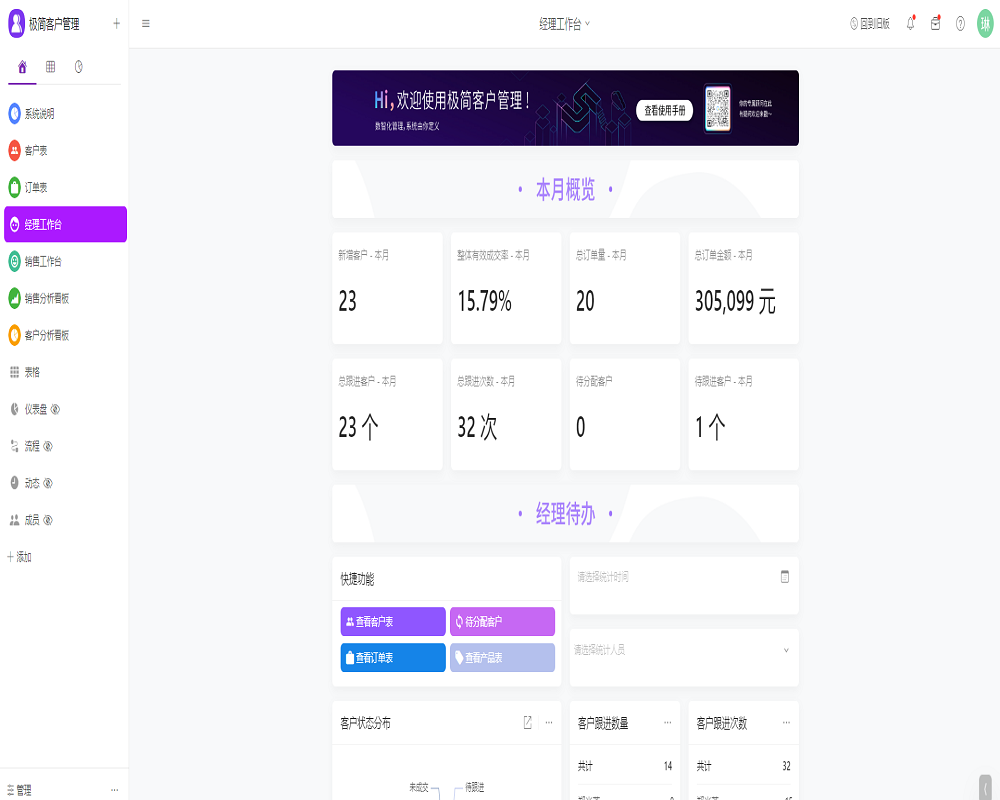

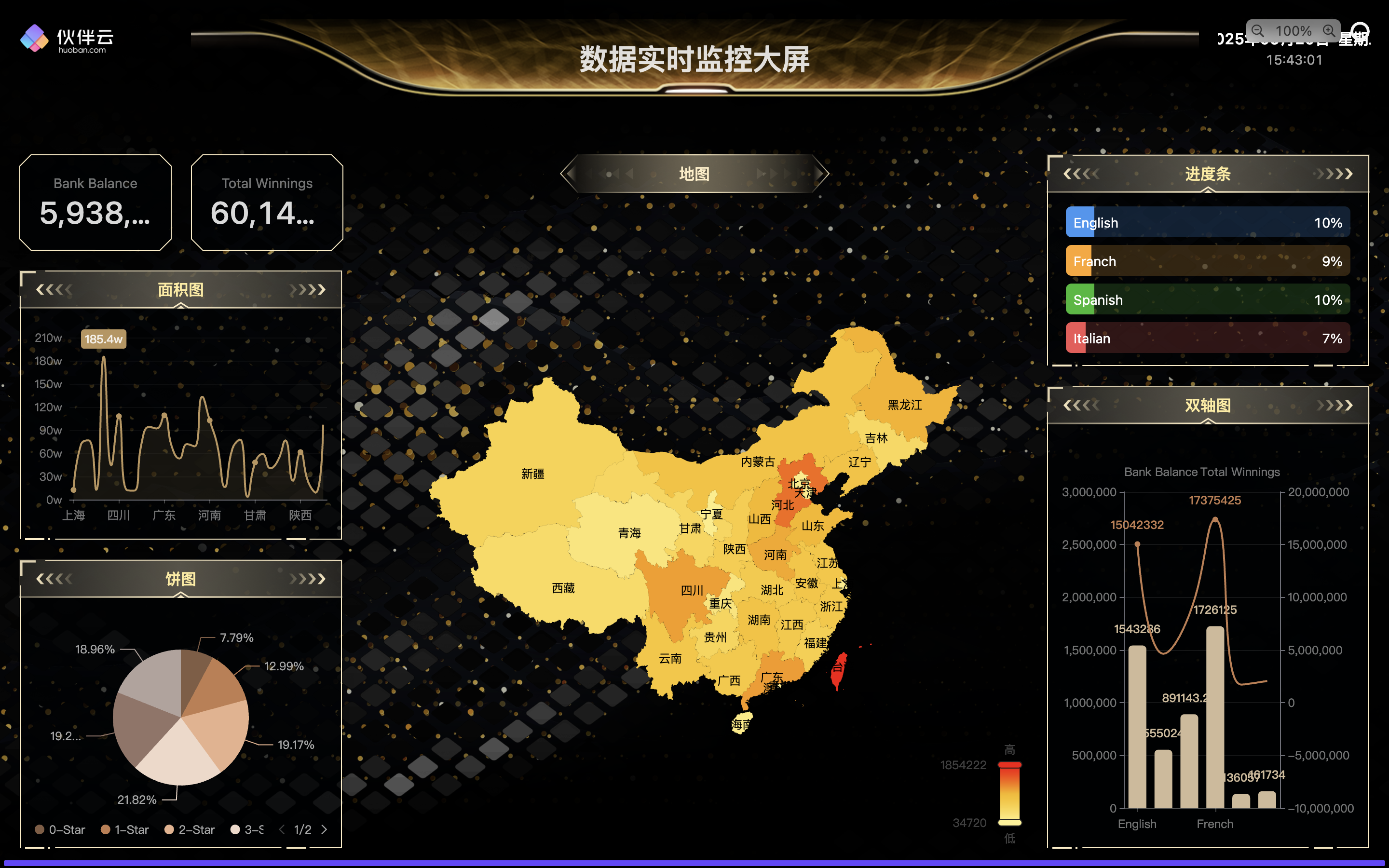

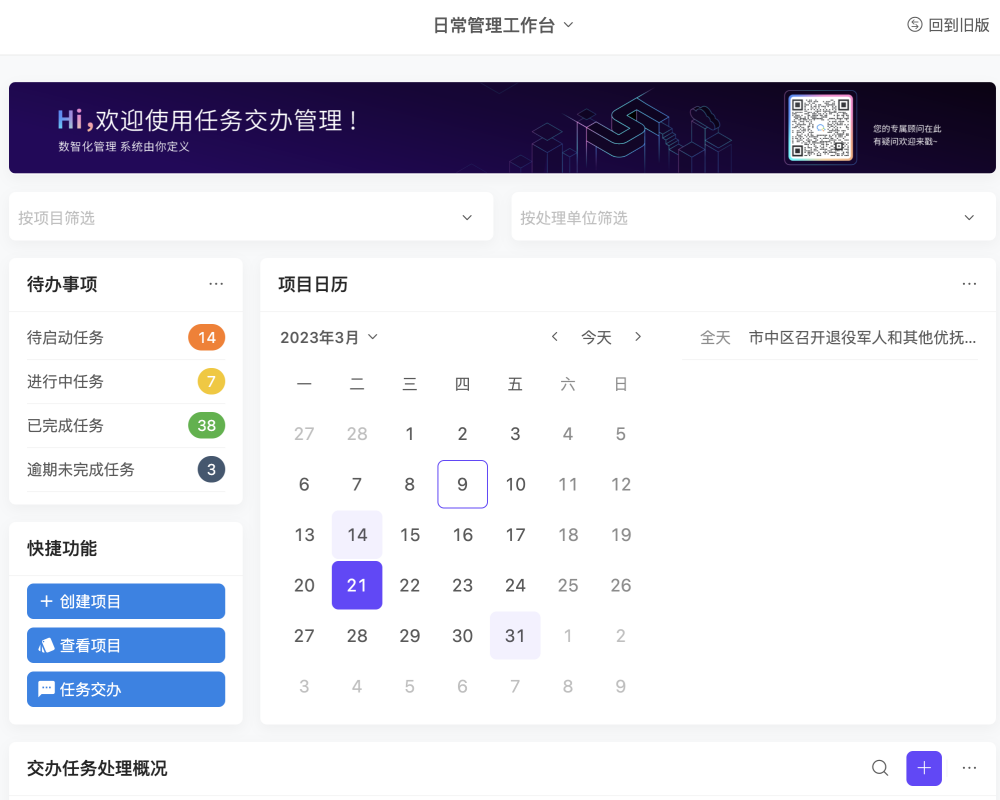

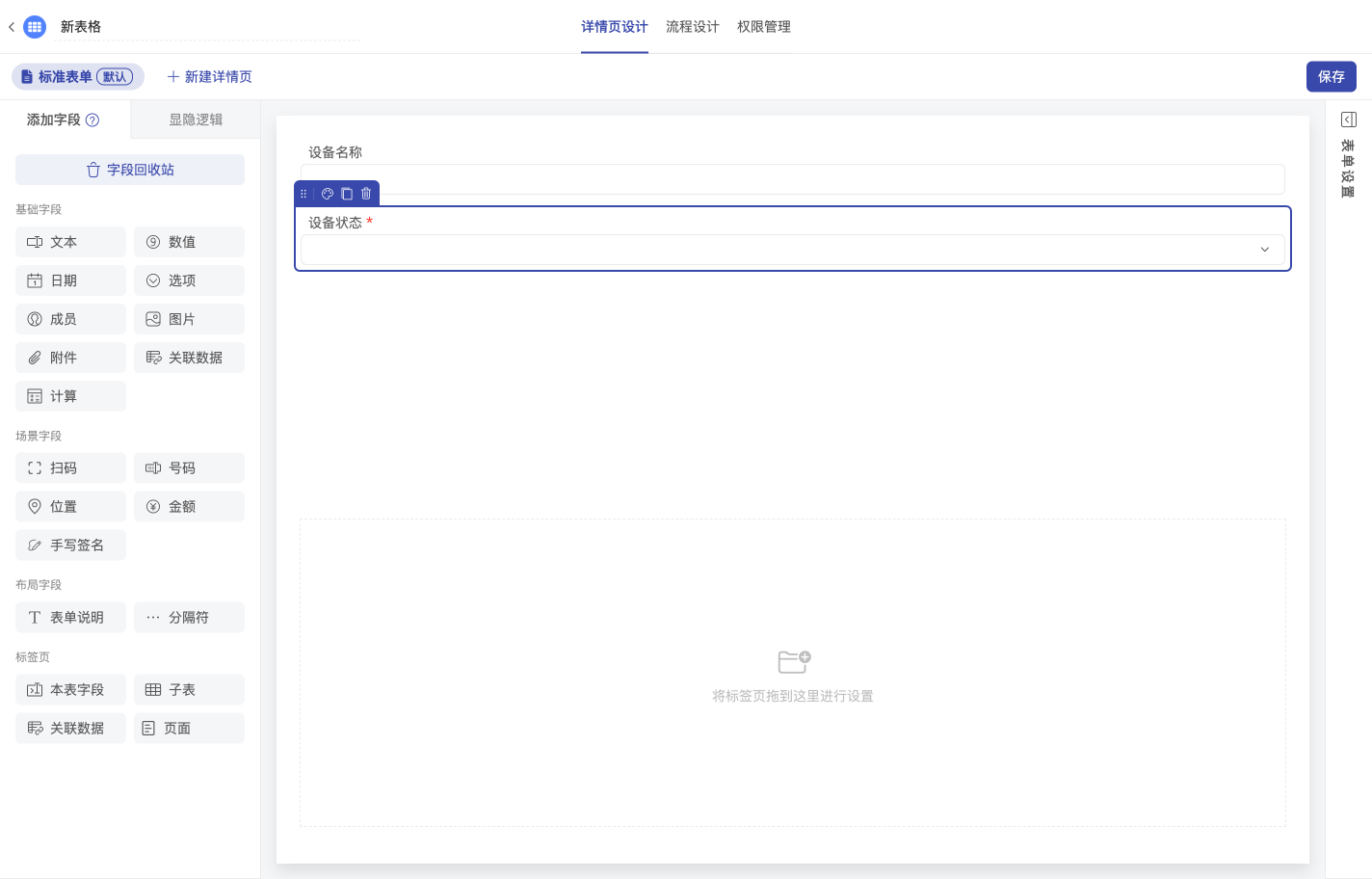

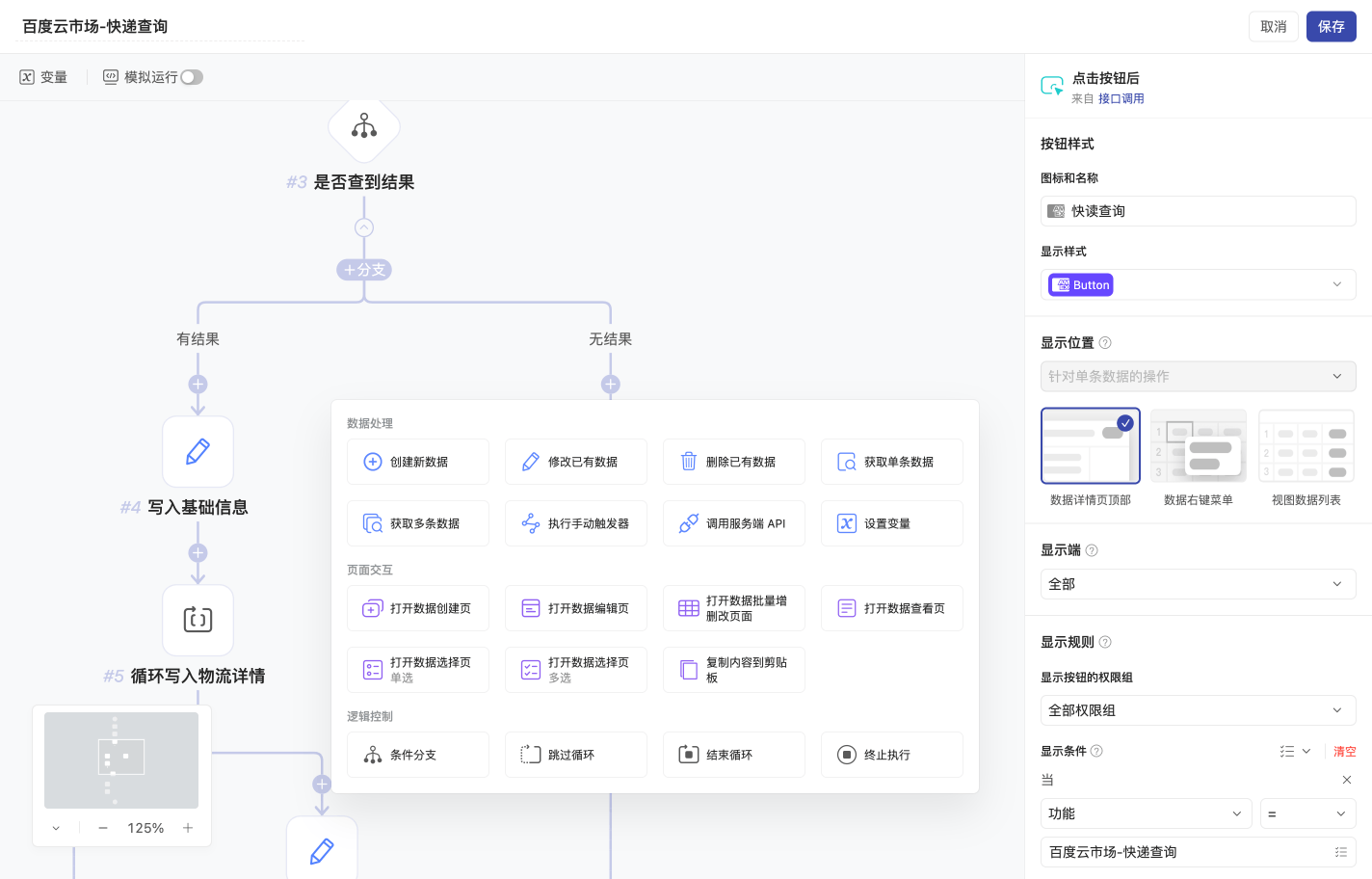

用零代码轻松搭建,在⼀个平台上管理所有业务

超多模板 开箱即用

能陪你创业,也能陪你上市

300万用户都在使用伙伴云,他们在竞争中脱颖⽽出

成为每个组织数字化历程中最值得信赖的伙伴

服务千行百业,值得您信赖